Let’s com #6 : L’IA dans les médias et les métiers de la communication

Depuis son lancement en novembre 2022, le robot conversationnel ChatGPT est au centre de l’attention. Accessible en version gratuite, il a déjà été utilisé par 1 Français sur 5 et il suscite de nombreux débats.

L’intelligence artificielle est déjà présente dans certains métiers. Mais parce qu’il produit des textes en apparence très proches de ce que ferait un être humain, ChatGPT semble ouvrir de nouvelles perspectives.

Les communicants, comme les médias, sont bien sûr concernés. Alors ? Facilitateur ou menace : comment s’emparer de ce nouvel outil, et l’utiliser intelligemment, en évitant ses failles ? Pour répondre à la multitude de questions que l’on se pose, Let’s com reçoit Amélie Cordier, chercheuse et experte en intelligence artificielle.

Retransciption du podcast :

“Ce site a réponse à tout, vraiment tout et n’importe quoi. Il peut répondre en quelques secondes, peut tenir une conversation avec vous gratuitement et dans presque toutes les langues. Une révolution.”

Certains journalistes se sont amusés à l’interviewer et tous ou presque en ont parlé. Cette révolution, c’est ChatGPT. Depuis son lancement en novembre 2022, le robot conversationnel est au centre de l’attention.

Accessible en version gratuite, il a déjà été utilisé par un français sur cinq et il suscite de nombreux débats. L’intelligence artificielle est déjà présente dans certains métiers, mais parce qu’il produit des textes en apparence très proches de ce que ferait un être humain, ChatGPT semble ouvrir de nouvelles perspectives. Les communicants, comme les médias, sont bien sûr concernés.

Alors, facilitateurs ou menaces, comment s’emparer de ce nouvel outil et l’utiliser intelligemment en évitant ses failles ? Pour répondre à la multitude de questions que l’on se pose, l’ETSCOM reçoit Amélie Cordier, chercheuse et experte en IA.

Anne : Bonjour Amélie.

Amélie : Bonjour.

Anne : Comment expliquez-vous le succès médiatique de ChatGPT ?

Amélie : Probablement parce que c’est la première fois qu’un outil d’intelligence artificielle est aussi facile d’accès pour le grand public et a des cas d’usage, des tests qu’on peut faire dessus, qui touchent vraiment tout le monde, tous les métiers, toutes les applications.

Pour la première fois, l’IA n’est plus réservée à une application en particulier ou un métier en particulier ou un domaine en particulier, mais devient vraiment tangible pour tous. Donc évidemment, tout le monde s’empare du sujet.

Techniquement, ce qu’il y a derrière ChatGPT, ce n’est pas nouveau, mais c’est probablement la première fois que les briques technologiques qui le constituent sont assemblées à une telle échelle. Et c’est aussi pour ça qu’on en parle beaucoup, c’est parce que ça donne des résultats assez impressionnants, dans plusieurs langues, sur plein de domaines d’application différents. On peut l’interroger aussi bien sur de la physique que de l’histoire ou des recettes de cuisine.

Anne : Vous aussi, vous êtes impressionnée ?

Amélie : En tant que chercheuse en IA et experte en IA, je suis à la fois bluffée par ce que ça fait et par la vitesse à laquelle les ingénieurs derrière ChatGPT ont réussi à mettre tout ça en production. Je suis impressionnée par la qualité des résultats, mais je ne suis pas surprise. Ce n’était pas inattendu, c’est arrivé probablement plus vite que ce que beaucoup d’entre nous imaginaient, mais ce n’était pas inattendu.

Et puis, je suis soucieuse de la façon dont on va traiter les conséquences de l’apparition de ChatGPT, mais plus généralement des outils de ce type et de leur usage dans la société.

Anne : Avant d’explorer cet impact, une question, comment ça marche ?

Amélie : D’abord, ChatGPT, c’est ce qu’on appelle un modèle de langage, un large language model en anglais, dont l’objectif est de générer du texte, essentiellement, en réponse à une question qu’on lui a posée. En anglais, on appelle ça le prompt.

C’est un modèle génératif. Son boulot, en tant qu’intelligence artificielle, c’est de générer du texte qui semble grammaticalement correct, qui est grammaticalement correct, on en est là, et qui soit plausible, qui soit statistiquement probable. Il y a beaucoup d’entraînement en intelligence artificielle en ce moment.

On va entraîner ce modèle en lui présentant une énorme quantité de textes. On va aller récupérer tout Wikipédia, on va récupérer tous les sites web accessibles sur Internet, on va récupérer des bases de données documentaires, on va se connecter aux bibliothèques nationales et récupérer tous les livres numérisés. J’en passe, et des meilleurs.

Et à partir de tous ces textes, le modèle va apprendre quelles sont les phrases statistiquement probables. Par exemple, si je vous dis « Bonjour, comment allez-vous ? », il est statistiquement probable que vous me répondiez « Je vais bien, merci, et vous ? » parce que souvent dans les textes, on trouve ce dialogue. Donc ça, c’est la première phase.

Et puis, évidemment, on ne va pas se contenter de lui dire « Génère-moi une phrase statistiquement probable », on va lui envoyer un feedback en disant « Ah oui, ça c’est une bonne phrase de réponse à ce que tu m’as demandé, ça c’est une mauvaise phrase de réponse à ce que tu m’as demandé. »

Donc, c’est un petit peu comme si, j’aime bien l’analogie de l’expert et du faussaire, c’est un petit peu comme si on voulait que notre modèle de génération de langage ce soit un faussaire, quelque chose qui soit capable d’imiter le langage humain, et puis on va avoir un expert qui lui dit « Ah oui, là, tu m’as bien berné » ou « Ah ben non, là, j’ai vu ton manège. » Et au fur et à mesure de cet entraînement, qui implique à la fois des humains qui disent « Oui, c’est bon, non, c’est mauvais », mais aussi des cas de test qu’on va récupérer à droite à gauche, à la fin de cet entraînement, on espère que le modèle entraîné va être de plus en plus compétent pour répondre à des choses, aux questions qu’on lui a posées.

Après, il y a une troisième phase dont on pourrait parler d’amélioration du modèle, poser des questions compliquées, l’empêcher de tenir certains propos dits racistes, sexistes, etc., pour le raffiner. Aujourd’hui, c’est comme ça que ça marche. Donc non, ce ne sont pas des humains qui écrivent les réponses que le modèle doit donner.

Le modèle génère des textes par construction statistique à partir de tout le contenu qui a été produit par les humains. Que les journalistes se fassent remplacer par ChatGPT ou par… Alors, encore une fois, je ne voudrais pas stigmatiser ChatGPT parce qu’en fait, il en fait moins de pubs et qu’ils font des choses similaires, peut-être dans une moins grande ampleur. Il y a beaucoup, par exemple, de matchs sportifs qui sont commentés par des intelligences artificielles qui se basent uniquement sur des observations statistiques du match.

Vous avez des résumés entiers, par exemple, de matchs de tennis qui sont écrits par des IA. Parce que s’il y a 15-0, 30-0, 40-0 et puis tout à coup que l’adversaire remonte, ce n’est pas difficile de faire générer à une IA le bout de texte qui dit « après un passage à blanc, Nadal est remonté en enchaînant trois aces et a fini par remporter le jeu et par là même le match ».

Il suffit d’avoir lu plein de résumés de matchs précédents pour savoir quelles sont les constructions de phrases qu’utilisent les commentateurs sportifs et écrire du texte comme s’il avait été dit de manière plus générale. En fait, ce qu’on voit avec les outils dont on parle, c’est qu’on arrive à faire du texte plus diversifié, plus créatif, où on a la capacité maintenant à lui donner des informations au fur et à mesure, à raffiner le contenu qui est produit.

En pratique, ce que ça veut dire pour les journalistes, c’est que c’est un outil supplémentaire pour le travail de journaliste. Ça va vous faire gagner du temps en tant que journaliste, ça va vous aider dans votre créativité si vous savez vous en servir. Et ça va commencer à générer des disparités entre ceux qui ont envie de s’en servir et ceux qui n’ont pas envie de s’en servir.

On pourrait parler de monétisation aussi, à mon avis le problème qui va se poser bientôt c’est entre ceux qui ont les moyens de s’en servir et ceux qui n’ont pas les moyens de s’en servir. Donc le métier va être transformé, mais comme tous les métiers sont transformés par l’informatique depuis des années, la vraie question c’est comment votre métier va être transformé, à quelle vitesse, et comment vous allez vous adapter. Finalement, ça va remettre en question ce qui est la véritable valeur du travail journalistique.

L’investigation, l’apport personnel que vous mettez dans votre façon de restituer l’information, votre enthousiasme, le différenciant par rapport au journal d’un côté, et ainsi de suite. J’insiste, aujourd’hui, les textes générés ne s’engagent pas sur le fait que les informations sont correctes, et il est tout à fait probable qu’un texte généré vous dise n’importe quoi. Probable, peut-être que c’est exagéré, mais possible en tout cas.

“ C’est une annonce sans doute un peu contrainte face au succès planétaire de ChatGPT, Google a annoncé hier soir le lancement de BARD, son propre agent conversationnel. Comme ChatGPT, BARD pourra répondre à une question en analysant son contexte.”

Amélie : Google a annoncé son entre guillemets concurrent à ChatGPT qui s’appelle BARD, et ils ont fait une démonstration en public en posant une question sur James Webb, et la réponse que BARD a donnée était complètement fausse, mais la démonstration a continué néanmoins, et c’est des astrophysiciens qui ont été obligés de dire « mais attendez, en fait vous ne pouvez pas dire que vous avez facilité l’accès à l’information en faisant du texte génératif, parce qu’en l’occurrence vous avez facilité l’accès à une information qui est fausse, et que tout le monde a cru de bon cœur pendant les sept premières minutes.

Et suite à cet événement, Google a quand même perdu 7% en bourse.

Anne : Mais les futures versions vont être meilleures, non ?

Amélie : Il va y avoir des évolutions de modèles, d’ailleurs pourquoi est-ce qu’il est accessible aussi facilement ? C’est parce qu’ils sont en train de collecter de la donnée sur ce qui marche et ce qui ne marche pas, mais ces modèles vont s’améliorer. L’enjeu, il n’est pas tant de faire en sorte que ces modèles fonctionnent, il est de faire en sorte que les gens, nous, soient conscients de ces limites et qu’on apprenne à avoir un esprit critique là-dessus.

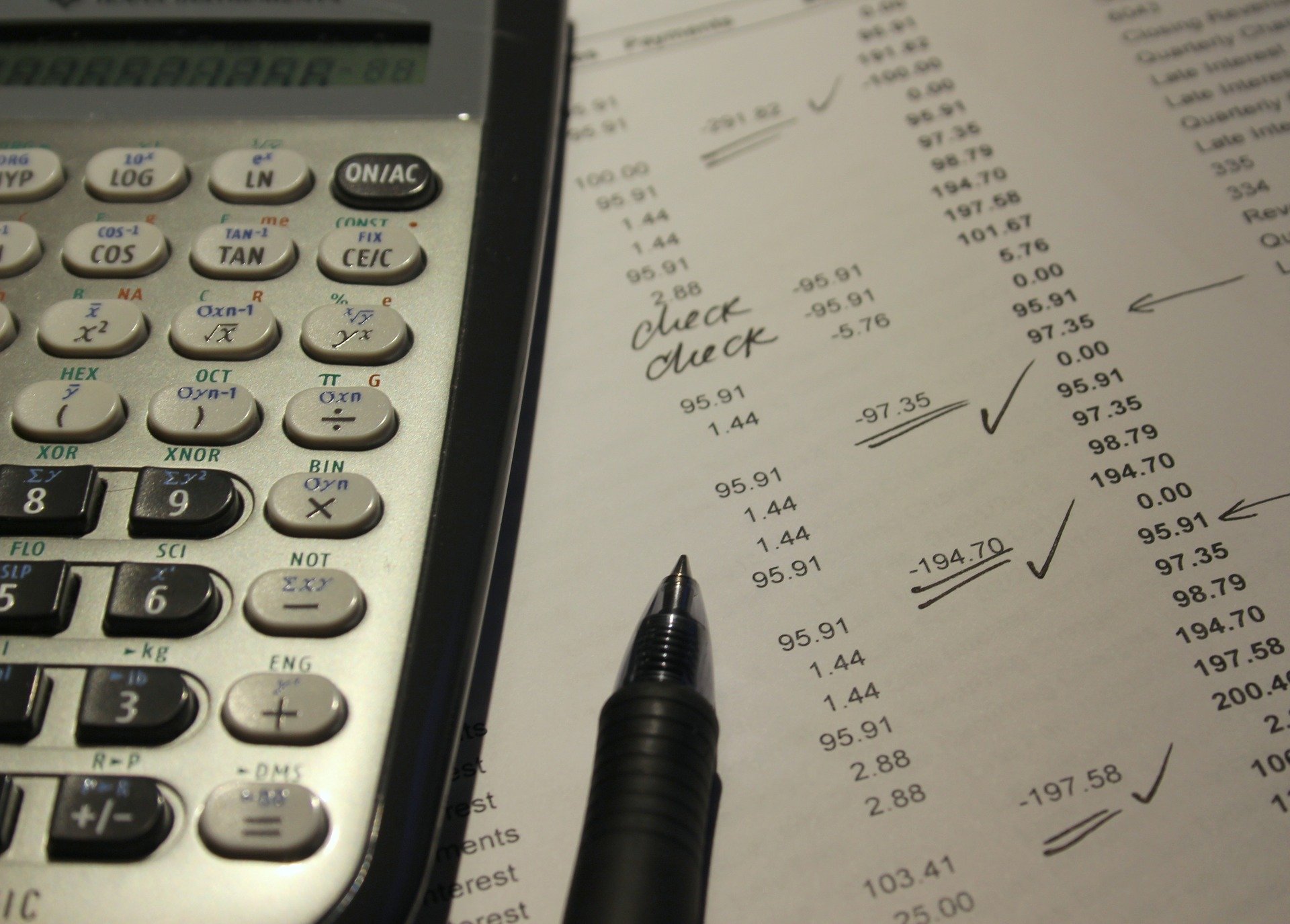

A chaque fois qu’on invente un nouvel outil pour faciliter une tâche, ça remet en question ce qui fait vraiment l’essence d’un métier. L’exemple que je préfère là-dessus, c’est les comptables. Les comptables, avant l’apparition d’Excel, des tableurs plus généralement, leur boulot c’était quand même de faire des additions, des soustractions et des multiplications dans des cahiers à petits carreaux, dans des livres de comptes.

Aujourd’hui, le métier d’un comptable, ce n’est plus du tout ça. Et Excel n’a pas tué les comptables, Excel a transformé leur métier. Pour moi, chez le GPT, ça va faire exactement la même chose.

Anne : Y’aurait-il des bons usages et des mauvais usages ?

Amélie : Tous les usages qui nous permettent de nous faire gagner du temps dans certaines situations, de nous aider dans un processus créatif, de nous débarrasser de certaines tâches qu’on estime fastidieuses au profit de tâches avec une plus forte valeur ajoutée, on peut considérer que ce sont des bons usages.

On a vu par le passé que l’IA permet de faire ce qu’on appelle des « deepfakes », de faire des fausses informations, de créer des fausses images, de faire parler des faux personnages dans les films ou autres.

Là, on ne fait qu’amplifier le phénomène, parce que maintenant, non seulement on peut faire des fausses images ou des fausses vidéos d’un président de la République, par exemple, mais en plus on peut lui faire dire un texte qu’on n’aura même pas écrit nous-mêmes mais qu’on aura demandé à une IA de générer. Tout ça à des fins de service d’un agenda politique quelconque. En fait, les mauvais usages, c’est les mauvaises intentions des humains qui sont derrière.

Pour moi, il faut aussi faire attention aux effets insidieux de l’utilisation de telles unités génératives. Qui est OpenAI pour décider de ce qui est politiquement correct ou pas, de ce qui est disciple ou pas, de ce qu’on a le droit de faire ou pas, lors du texte généré ? Et est-ce que nous, en tant que société, on veut accepter que les réponses soient formulées de telle façon plutôt que de telle autre, parce que quelqu’un, un jour, a arbitré que c’était ça l’éthique ?

Il y a beaucoup de gens aujourd’hui qui prennent ce que ChatGPT dit pour argent comptant, alors qu’en fait, il n’y a aucun moyen de vérifier la véracité des faits qui sont cités par ChatGPT. D’ailleurs, le modèle ne s’engage pas à vous donner des informations vraies. Le modèle s’engage à vous dire des choses statistiquement probables.

Et je peux vous dire que la date de naissance de Marilyn Monroe est 1536. En fait, c’est statistiquement probable que quelqu’un qui s’appelle Marilyn Monroe soit né en 1536. La question, c’est, est-ce que c’est cette Marilyn Monroe à laquelle je pensais quand j’ai généré ce bout de texte ? Ça, je ne peux pas vous le prouver.

Il faut se dire que ce sont les concepteurs, les créateurs de ChatGPT qui, quelque part, ont décidé de ce qu’on avait le droit de dire ou de ne pas dire, droit de penser ou pas penser. En fait, on est tout à fait en droit de se dire qu’on n’a pas forcément envie que ce soient les ingénieurs derrière ChatGPT et les mécanismes qui ont abouti à la construction de ce modèle qui décident de ce qui est juste et ce qui n’est pas juste.

Anne : Contre quoi vous mettez-vous en garde ?

Amélie : J’ai envie de tenir des propos qui invitent à faire preuve d’esprit critique.

Et je pense que le problème avec ces outils qui sont bluffants, et encore une fois, je suis la première à être bluffée, c’est qu’ils sont tellement entre guillemets « cool » qu’on ne peut pas s’empêcher de jouer avec, et on jette assez facilement nos valeurs, nos réserves et notre jugement parce qu’on a envie de s’amuser, et je ne suis pas sûre que ce soit une bonne idée.

Donc si j’ai un message à faire passer, c’est qu’il faut exercer son esprit critique. Éviter qu’on devienne des moutons à croire bêtement tout ce que nous dit l’IA, parce que l’IA est majoritairement plus intelligente que nous sur certains sujets.

Avec des outils comme ça, l’accès à l’information semble encore plus facile, mais il ne faudrait surtout pas tomber dans le travers du « c’est tellement facile que je ne fais même plus l’effort de vérifier ma source ». Et la question, elle est dans comment vous voulez utiliser l’outil, enfin comment les communicants veulent utiliser l’outil. C’est difficile de ne pas accepter l’utilisation d’un chat GPT, par contre on peut envisager de le réglementer.

Anne : Au-delà de nos métiers, selon vous, quels sont les enjeux sociétaux majeurs ?

Amélie : Il y a deux sujets qui sont fondamentaux et sur lesquels on devrait s’interroger en tant que société.

Le premier sujet, c’est le sujet de la consommation énergétique de cet outil pour s’entraîner sur un synchro au volume de données, on parle de serveurs dont vous ne pouvez même pas imaginer le fait. Ça c’est la première chose, et la deuxième chose c’est qu’aujourd’hui tout le monde fait des petits tests sur chat GPT en consentant librement à partager nos données, les données de nos petits tests, les choses qu’on a envie que chat GPT nous dise, intimes ou moins intimes, avec OpenAI tout simplement.

Et donc toute la question de la gouvernance des données, de la privacy, de la souveraineté des données, elle est en train d’être remise sérieusement en question, et ça, ça pose la question sociétale de, est-ce qu’on accepte ça tout simplement ? Est-ce qu’on accepte l’utilisation de ces outils ? Aujourd’hui on l’accepte parce que c’est fun, que tout le monde le teste, et que donc il faut aller dans cette mouvance, mais on pourrait décider en tant que société de ne pas accepter tout simplement.

Et donc chat GPT il existe, les ingénieurs qui sont derrière encore une fois, ils ont sûrement plein de bonnes intentions, mais la vraie question c’est qu’est-ce qu’on va en faire en tant que société ?

Anne : Merci Amélie, au revoir.

Amélie : Avec plaisir, au revoir.

PARTAGEZ !